Spring Boot dev-tools实现项目热部署自动重启

我们有时候需要这样的功能,代码修改后,希望项目能自动重启,不然每次都要手动 Rerun 一样,很麻烦。

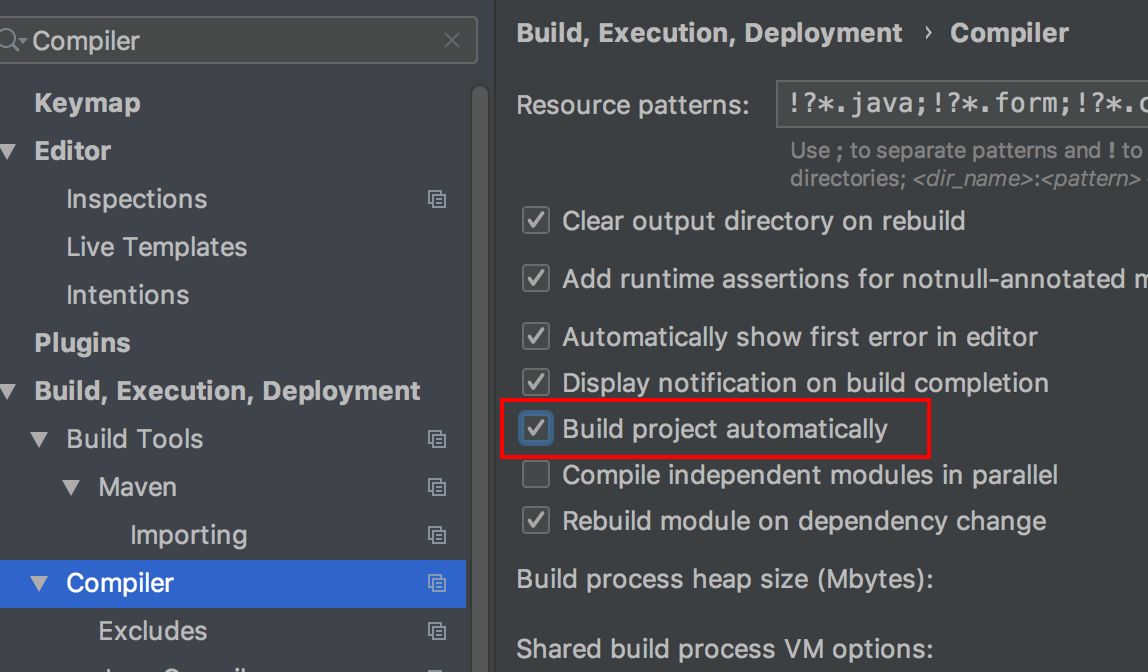

开启IDEA的自动编译

在 Compiler 里面勾选 Build project automatically 自动构建项目。

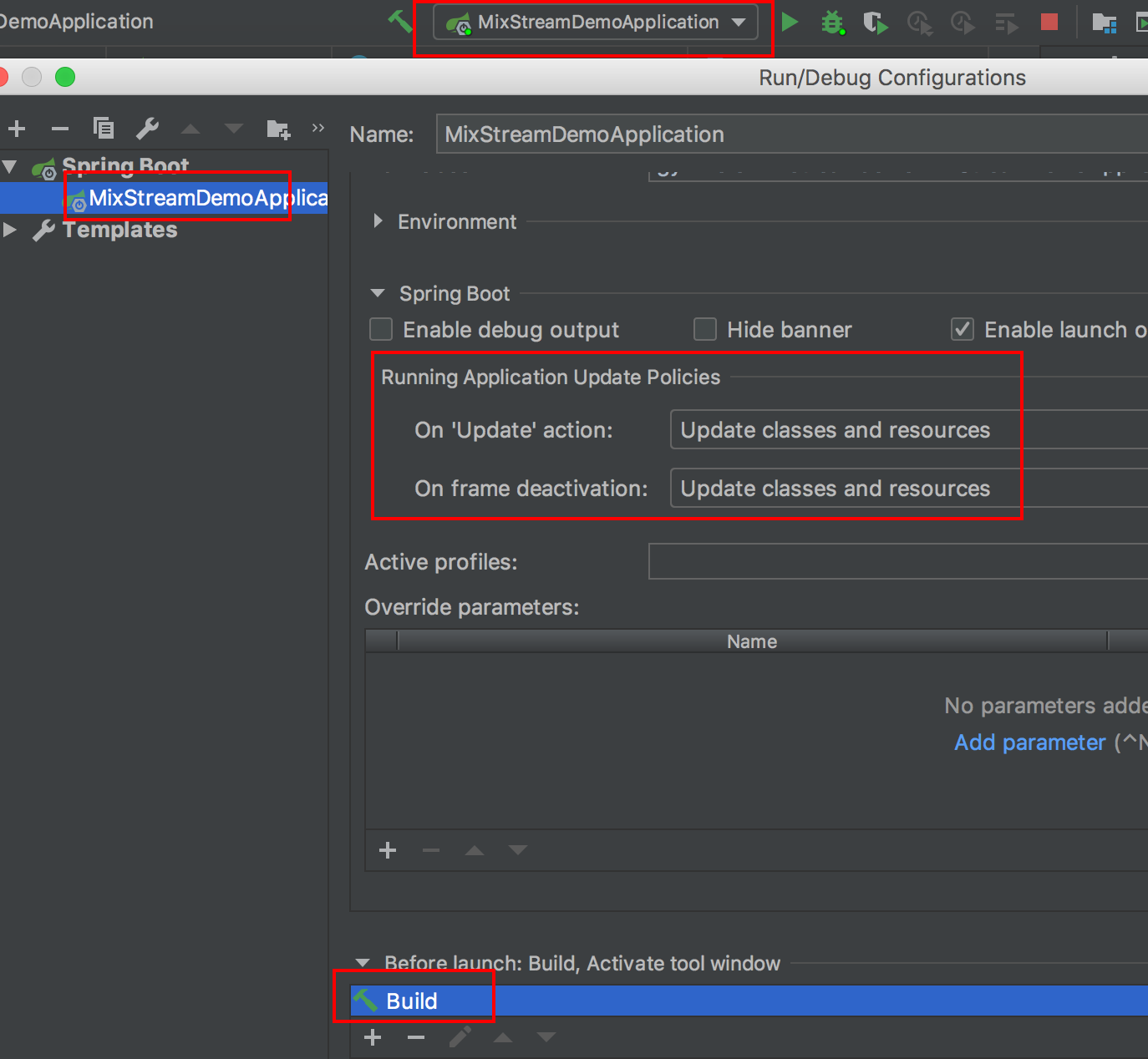

开启IDEA的热部署策略

点击 Edit Configurations…

在 pom.xml 加入依赖

1 | <dependency> |

之后,修改代码以后,项目会自动重新编译并重启了,开发也更有效率了。